E038_El_salto_de_Word2Vec_a_BERT

Artikel konnten nicht hinzugefügt werden

Leider können wir den Artikel nicht hinzufügen, da Ihr Warenkorb bereits seine Kapazität erreicht hat.

Der Titel konnte nicht zum Warenkorb hinzugefügt werden.

Bitte versuchen Sie es später noch einmal

Der Titel konnte nicht zum Merkzettel hinzugefügt werden.

Bitte versuchen Sie es später noch einmal

„Von Wunschzettel entfernen“ fehlgeschlagen.

Bitte versuchen Sie es später noch einmal

„Podcast folgen“ fehlgeschlagen

„Podcast nicht mehr folgen“ fehlgeschlagen

-

Gesprochen von:

-

Von:

Über diesen Titel

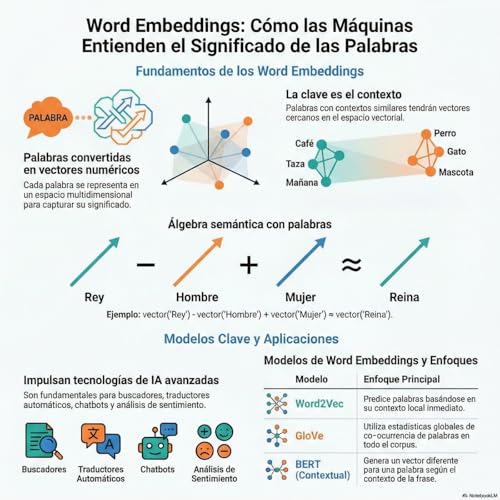

La inteligencia artificial puede aprender a entender el significado de las palabras a través de modelos como Word2Vec, Glove y FastText, que utilizan vectores para representar las relaciones semánticas entre palabras. Estos modelos pueden aprender a partir de grandes cantidades de texto y capturar relaciones complejas, como la similitud entre palabras y la relación entre conceptos. Sin embargo, tienen limitaciones, como la creación de representaciones estáticas que no dependen del contexto. El modelo BERT, desarrollado por Google en 2018, revolucionó este campo al introducir un enfoque bidireccional que permite al modelo leer y entender el texto de manera más similar a como lo hace un humano.

Noch keine Rezensionen vorhanden